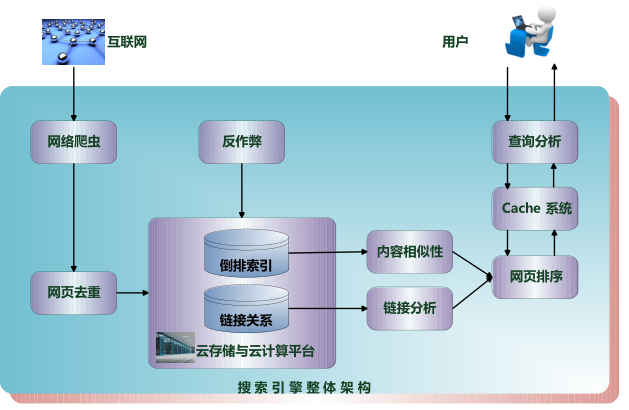

爬虫是一门随着互联网大数据而应运而生的产物,它主要是为了在海量的网络数据中采集分析有效的数据而诞生的一门技术。

无需多言,爬虫技术工程师已经成为互联网+时代的新宠。各个领域均能看到对他们的需求,而这个行业兴欣向荣发展的同时,必然也会遭遇一些壁垒。

由于爬取数据将反复在挂在目标网站上,造成一定的目标网站的压力,所以许多网站都有应对爬虫的反爬虫技术壁垒。

最简单直接的就是针对同一ip不断快速频繁访问网站的ip进行封锁。

当然遇此情况,咱们也可以降低爬取的效率,缓解目标网站的压力,但是对于需要获取大量信息,针对海量信息进行删选甄别的项目

而言,时间效率无疑是不能等的。那只有通过不停更换ip来避免被封锁,高效率的爬取数据。

目前市场上爬虫代理地址提供商很多,很多提供商都是采集公网上的透明代理,可用率不高,并且极为不稳定,网速慢是必然的,针对专业的爬虫工作,还是建议采用专门针对爬虫业务的爬虫代理地址,它高效、稳定,能够有效的提高工作效率。

那爬虫代理怎么用呢?

1、选择一个靠谱的爬虫代理地址

2、声明一个httpClient时间对象,设置好超时时间。

3、根据你所用的服务器,设置代理,建议用火狐。

4、测试你当前的代理是否可用(PS:如果你选择一个靠谱的代理提供商提供的爬虫代理地址,这一步就能节省很多时间。

5、查看服务器是否对你进行屏蔽,若返回的是SC-FORBIDDEN,则表示对你屏蔽,不可行。那就得重复第四步的步骤,直到可用为止。

爬虫是一门技术活儿,需要耐心、细心,还需要好的工具,不然一切只是白做工!

当前位置:

当前位置: